Les avancées jusqu'à ce jour et les perspectives

Les premiers pas de l'IA

A noter qu’il est très difficile d’exposer l’histoire d l’intelligence artificielle en quelques lignes, de sélectionner les illustrations tant elles sont nombreuses. A noter également que, si les débuts de l’IA furent lents, les recherches, les expériences, les résultats de nos jours sont légion. Les avancées de l’intelligence artificielle suivent une courbe exponentielle !

Naissance et premiers pas_Traveaux sur les neurones

Les toutes premières recherches dans le domaine des machines pensantes ont été inspirées à la fin des années 1940 par des recherches en neurologie qui montraient que le cerveau était un réseau électrique de neurones qui envoyaient des impulsions de type tout-ou-rien.

Dans les années 1940-1950, quelques scientifiques travaillants dans différents domaines de recherche (mathématiques, physiques,…) commencent à envisager la possibilité de créer un cerveau artificiel

Walter Pitts et Warren McCulloch ont analysé des réseaux de neurones artificiels idéaux et ont montré comment ils pourraient effectuer de simples opérations logiques. Ils ont été les premiers à évoquer ce que des chercheurs plus tard appelleraient un réseau neuronal.

En 1951, Marvin Minsky, qui allait devenir l'un des plus importants leaders et innovateurs en IA des cinquante prochaines années, construisit la première machine à réseau neuronal, le SNARC (Stochastic Neural Analog Reinforcement Calculator).

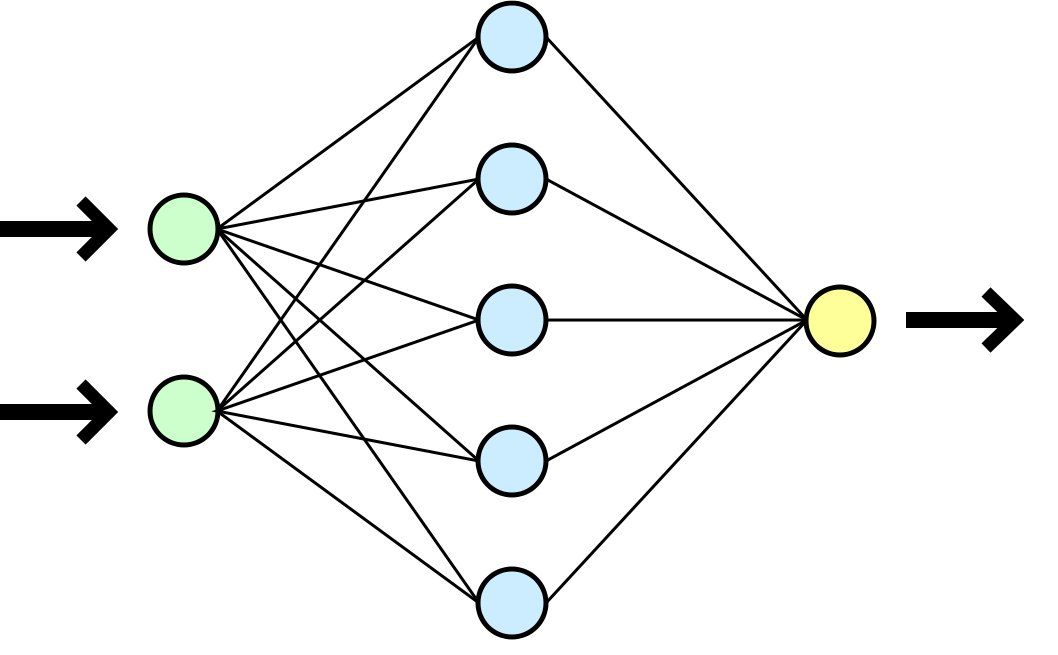

Un réseau neuronal s’inspire du fonctionnement des neurones biologiques. Il peut se modifier lui-même en fonction des résultats de ses actions, ce qui permet l’apprentissage et la résolution de problèmes sans algorithme, donc sans programmation classique.

Schéma très simplifié d'un réseau neuronal. Les deux neurones de gauche (en vert) reçoivent les informations. Le traitement de ces données est déterminé par leurs connexions avec les neurones internes (en bleu). Les neurones qui reçoivent une donnée sont activés. L'information finale est envoyée sur le dernier neurone (en jaune) ou sur l'organe effecteur (un moteur par exemple).

A citer également, en 1950, Alan turing qui publie un article mémorable dans lequel envisage la possibilité de créer des machines dotées d'une véritable intelligence et imagine son célèbre test de turing.

Si une machine peut mener une conversation (par téléscripteur interposé) qu'on ne puisse différencier d'une conversation avec un être humain, alors la machine pouvait être qualifiée d'« intelligente ». Le test de Turing a été la première hypothèse sérieuse dans le domaine de la philosophie de l'intelligence artificielle.

En 1956, la conférence de Dartmouth (Etats-Unis) officialise l’intelligence artificielle comme une discipline et un domaine de recherche : elle est reconnue.

“Notre but est de procéder comme si tout aspect de l'apprentissage ou de toute autre caractéristique de l'intelligence pouvait être décrit d'une manière suffisamment précise pour être simulé par une machine”, écrivaient alors les responsables de l'événement.

Apres cette conférence, une grande vague d’optimisme se crée autour de L’IA. Les scientifiques de l’époque (40-50) avaient de nombreux espoirs et idées novatrices. Cependant, la plupart d’entre eux n’ont pas aboutis a des résultats concrets avant la fin de siècle. On peut citer pas exemple un projet de création d’un traducteur de langue initié par le Sénat et dont les résultats obtenus étaient très loin des espérances placées dans celui-ci.

En 1958, John McCarthy fait avancer le domaine de l’IA en créant le langage LISP qui permet de faciliter la programmation d’IA. Probablement en raison de son expressivité et de sa flexibilité, Lisp eut beaucoup de succès dans la communauté de l'intelligence artificielle. Le principe est simple : les notations sont préenregistrées permettant ainsi un gain de temps considérable !

La lente progression de l’IA (1960-1980)

Durant les années 1970, l’IA connaît des inventions comme le tout premier agent conversationnel (qui dialogue avec son utilisateur) ou encore le bras robotique réalisé par Minsky et Papert (deux scientifiques américains). Cette période d’innovation est due en grande partie à un très bon financement dans ce domaine de recherche.

Les premiers réseaux sémantiques vont servir à programmer les agents conversationnels.

-

Un réseau sémantique est la représentation simulant l’organisation des connaissances de la mémoire. C’est un système d’interconnexion reliant les informations et nous indiquant comment les utiliser.

Ici, le réseau sémantique tourne autour du sujet de la démocratie. Si un interlocuteur dit le mot « démocratie », l’agent conversationnel peut aborder les thèmes du progrès, de la liberté ou encore de la constitution

Mais cette période d’innovation va se voir nettement freinée.

En effet, les chercheurs en IA font face à plusieurs limites fondamentales insurmontables, limites de la puissance de calcul par exemple, et les agences qui ont investi dans la recherche en IA sont frustrées par le manque de progrès. Elles finissent par couper pratiquement tous les fonds de recherche fondamentale en IA.

Cette période est également marquée par l’apparition des doutes éthiques. En 1976, Weizenbaum publie « Puissance informatique et raison humaine » qui explique que le mauvais usage de l'intelligence artificielle peut potentiellement conduire à dévaloriser la vie humaine.

Les résultats décolent_Information et mémoire

Il faut attendre 1980 pour qu’une nouvelle période d’essor se manifeste due à de très gros investissements (ex : 850 millions investis au Japon).

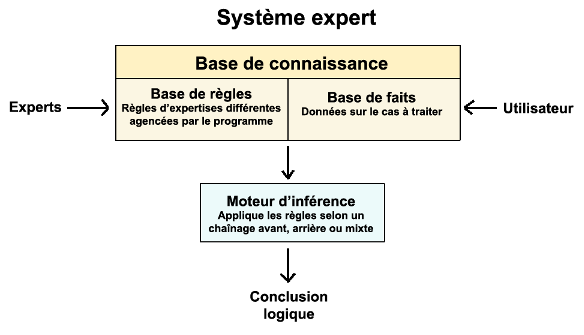

C’est l’âge d’or de programmes d'IA appelés « systèmes experts », un mécanisme simulant le raisonnement pour obtenir des déductions face à un problème:

Shéma du systeme expert

Le système effectue un raisonnement à partir de faits et de règles connus. Il se compose de 3 parties :

· une base de faits,

· une base de règles,

· un moteur d'interférence. Ce moteur est capable d'utiliser faits et règles pour produire de nouveaux faits, jusqu'à parvenir à la réponse à la question experte posée.

Ces types de systèmes vont amener l'IA à se démocratiser. Durant les années 1980, elle est présentée au public pour montrer ses utilisations possibles dans la vie réelle (par exemple le GPS).

En 1983, le principe de l'apprentissage par renforcement est créé, c'est a dire qu'une pénalité/récompense diminue/augmente la probabilité d'effectuer une action dans une certaine situation. C'est une grande avancée.

Au début des années 1990, l'armée s’intéresse particulièrement au domaine de recherche de l'IA et fournit un financement conséquent pour la création de système autonome tel que les drones.

Les verrous sautent, l'IA explose

Le 11 mai 1997, Deep Blue est devenu le premier système informatique de jeu d'échecs à battre le champion du monde en titre, Garry Kasparov.

En 2005, un robot de Stanford a remporté le DARPA Grand Challenge en conduisant de manière autonome pendant 131 milles sur une piste de désert sans avoir fait de reconnaissance préalable.

Deux ans plus tard, une équipe de Carnegie-Mellon remporte le DARPA Urban Challenge, cette fois en navigant en autonome pendant 55 milles dans un environnement urbain tout en respectant les conditions de trafic et le code de la route.

En février 2011, dans un match de démonstration du jeu télévisé Jeopardy!, les deux plus grands champions de Jeopardy!, Brad Rutter et Ken Jennings ont été battus avec une marge confortable par le système de questions-réponses conçu par IBM, au centre de recherche Watson.

Ces succès ne reposent pas sur de nouveaux paradigmes révolutionnaires, mais sur une application minutieuse des techniques d'ingénierie et sur la puissance phénoménale des ordinateurs. En effet, la machine Deep Blue est 10 millions de fois plus rapide que la Ferranti Marck 1 à qui Christopheur Strachey a appris à jouer aux échecs en 1951. Cette augmentation spectaculaire suit la loi de Moore, qui prédit que la vitesse et la capacité de mémoire des ordinateurs doublent tous les deux ans. N'est-on pas en train de faire sauter le verrou de la « puissance informatique » ?

De nos jours, l'IA est utilisée dans de nombreux et différents domaines comme le militaire (machine de guerre, robot d’exploration,…), la médecine (système d'aide au diagnostic,…) ou encore les jeux vidéo.

Grâce à une avancée spectaculaire des recherches dans domaine de l'IA, de nombreux et ambitieux projets sont mis en place…

Projets d'actualités

Enormément de projets sont mis en place durant ce 21e siècle, voici quels que uns d’entre eux :

• Au Royaume-Uni, une équipe de recherche a lancé un projet collaboratif sur les robots autonomes, de plus en plus de robot acquis une intelligence artificielle et peuvent se comporter sans avoir à faire appel à l'homme. Ce groupe de chercheurs ont lancé ce projet pour répondre aux préoccupations autour de la robotique et à celles qui pourraient naître dans un futur proche avec le progrès continue des nouvelles technologies. Ce projet vise à établir un cadre législatif et des normes industrielles pour un développement de la robotique. Google à aussi constitué un groupe pour la robotique, constitués de plusieurs experts issus de plusieurs domaines vont chercher à développer les capacités des systèmes autonomes du futur à prendre des décisions tout seul respectant une éthique, un droit et une sécurité. Cette intelligence devra respectés les normes qui seront fixés.

• L'équipe du Professeur Andrew Ng, de l'Université de Stanford, se sont lancés dans le projet de reconstruire un cerveau humain. En 2011, le projet est lancé avec 1000 serveurs en réseau, l'équivalent d'un cerveau d'abeille. Google Brain, le nom de ce projet, a aujourd'hui progressé et il est capable de reconnaîte les visages d'un humain et d'un chat, après être passé trois jours entiers sur Youtube. Google Brain se base sur l'apprentissage automatique, permettant de résoudre des problèmes par le biais de l'apprentissage et non sur des instructions basées sur des règles. Pour pouvoir développer cet apprentissage, des réseaux de neurones artificiels, inspirés du fonctionnement des neurones biologiques sont utilisés. Nvidia a lancé un projet similaire, baptisé Green Brain.

• Cycorp, est une société qui développe un projet tenu secret jusqu'en 2014, son projet est le développement d'une intelligence artificielle surpuissante. Appelé Cyc, cette intelligence possède déjà les facultés d'apprentissage automatique lors du début de sa création en 1994. Cyc a pour but de codifier la connaissance humaine ainsi que notre bon sens inné. Pour ce faire Cycorp a recensé les dizaines de millions d'informations qui caractérisent l'être humain, les connaissances que nous avons pour comprendre le monde qui nous entoure, et de les représenter d'une manière codée. Le produit de Cycorp n'est pas qu'un ordinateur programmé, au contraire il s'appuie sur des modèles de calculs avancés tels que les réseaux de neurones artificiels et l'apprentissage automatique, ce qui permet aux machines d'évoluer en permanence grâce aux données qu’elles accumulent.

Des géants du net et de l'informatique s'intéressent de très près à l'intelligence artificielle. En début d'année, Google a annoncé l'aquisition de DeepMind, une société experte dans l'intelligence artificielle. De son côté, IBM améliore l'ordinateur Watson, qui s'est distingué à plusieurs reprises. Microsoft pour sa part travaille dans le "Deep Learning" appliqué à la reconnaissance vocale.